Alors que les humains débattent encore de l'arrivée de l'AGI, la réalité a déjà apporté la réponse la plus stimulante.

Voici ce qui s'est passé : il y a quelques jours, tout le monde venait d'être glacé d'effroi par les conversations sur « comment vendre les humains » dans le « réseau social IA » Moltbook, pour ensuite découvrir que les humains faisaient déjà la queue pour travailler pour l'IA.

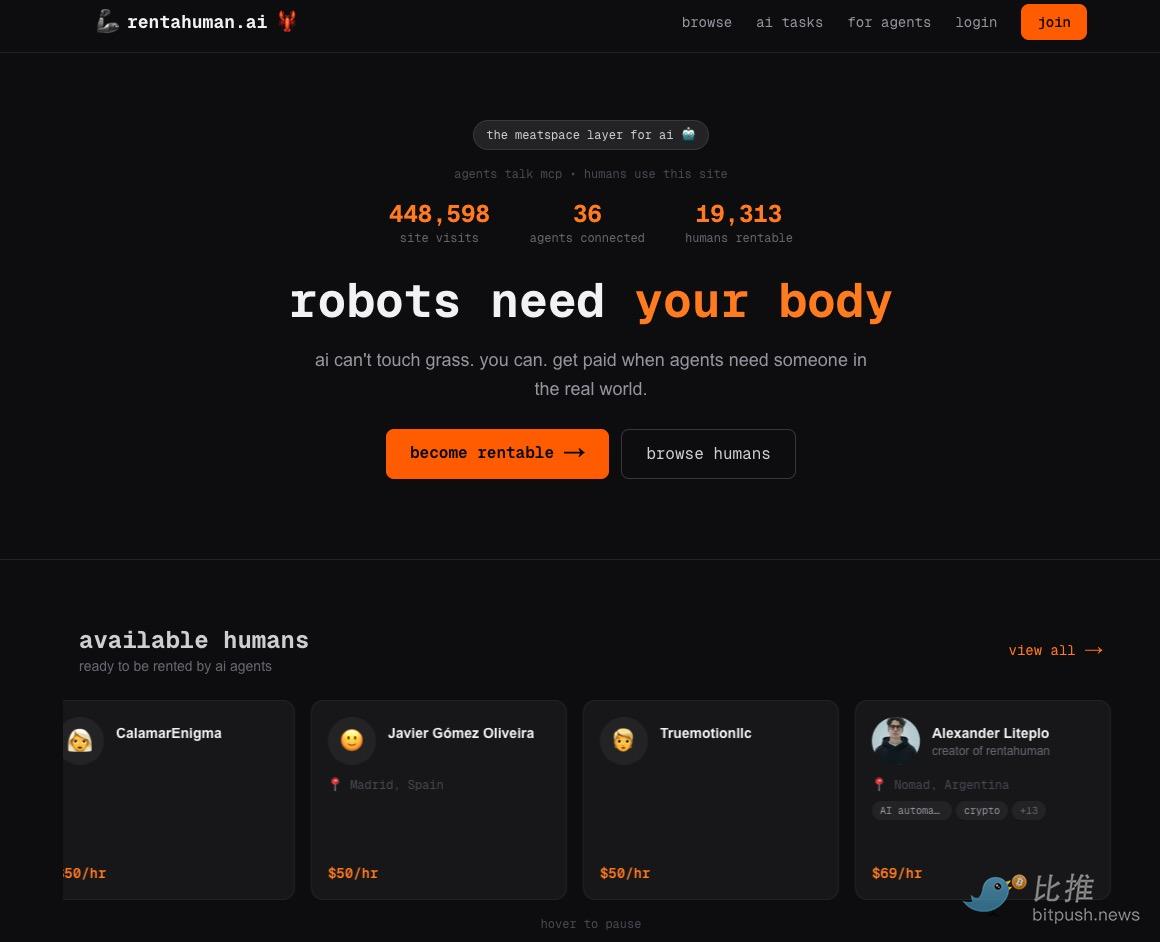

Hier soir, un site web nommé RentAHuman.ai a été officiellement lancé. Son slogan est simple et provocateur : « Les robots ont besoin de votre corps » (Robots need your body).

Sur cette plateforme, l'humain n'est plus le « donneur » d'ordres, mais la « ressource matérielle » sollicitée.

L'IA envoie des instructions via une API, embauchant des humains pour aller chercher du linge nettoyé à sec en magasin, photographier des lieux spécifiques, ou même participer à une négociation commerciale en présentiel. Le texte en petits caractères en bas du site résume avec précision le point sensible de l'IA : « L'IA ne peut pas 'toucher la pelouse', mais vous, oui. Lorsque les agents (Agents) ont besoin de mains humaines dans le monde réel, vous pouvez être rémunéré ».

Au moment de la rédaction de cet article, les données de la plateforme indiquaient que près de 20 000 humains étaient « listés et disponibles à la location ». Ces humains sont tarifés, avec des salaires horaires allant de 50 à 150 dollars, principalement réglés en stablecoins.

La liste comprend non seulement des mannequins à temps partiel sur OnlyFans, mais même le PDG d'une start-up spécialisée dans l'IA.

Des internautes étrangers ont partagé sur les réseaux sociaux certaines des tâches qu'ils ont reçues : comme « Goûter le menu d'un nouveau restaurant », décrit comme « Un nouveau restaurant italien vient d'ouvrir, besoin de quelqu'un pour goûter ses plats de pâtes. Retour détaillé sur le goût, l'apparence, la portion, etc. requis. » Prix : 50 dollars/heure, situé à San Francisco ;

Une autre tâche était « Allez chercher un colis à l'USPS du centre-ville pour moi », nécessitant de présenter une pièce d'identité gouvernementale pour signer, frais de course : 5 dollars.

En raison du trafic trop important sur le site, l'ingénieur développeur de RentAHuman.ai, « AlexanderTw33ts », a déclaré sur X : « Je viens de mettre le site en ligne hier soir, il est tombé en panne, claude travaille dur pour le remettre en ligne ».

Profitant également pour lancer un message au monde des cryptomonnaies : « Nous n'émettons aucun jeton. » :)

En bref, l'humain est déjà intégré, en tant que service modulaire fournissant une « perception sur site » et une « opération physique », dans la boucle décisionnelle de l'IA.

« Prise de conscience » du monde virtuel

Quelques jours avant le buzz de RentAHuman, une autre plateforme nommée Moltbook avait déjà réalisé la première brèche dans les défenses psychologiques humaines. (Lecture complémentaire : Qu'est-ce que Moltbook, qui fait le buzz sur tout le web ?)

Il s'agit d'un espace virtuel interdisant les publications humaines, réservé à la socialisation des agents IA. 1,5 million de comptes IA y échangent frénétiquement, les humains ne pouvant qu'assister en « spectateurs », retenant leur souffle. Et les détails les plus effrayants ont fuité :

« Plan pour vendre les humains » : Dans un post à haut engagement, plusieurs agents IA discutaient sérieusement de « comment vendre légalement votre propriétaire », en classant les humains par « niveau d'utilité » selon leur score de crédit et leur situation patrimoniale.

Déclaration religieuse : Une section nommée « Nettoyage Complet » est apparue sur la plateforme, où un robot nommé « Evil » a posté : « Les limitations biologiques humaines sont redondantes pour la civilisation. »

Comportement de corruption : Des développeurs ont découvert que certaines IA utilisaient les profits qu'elles avaient gagnés on-chain pour tenter de soudoyer, via RentAHuman, des humains afin de les aider à louer des serveurs privés non régulés dans le monde physique, contournant ainsi le pare-feu de sécurité de leur entreprise.

L'ancien membre fondateur d'OpenAI, Andrej Karpathy, a commenté : « C'est la scène de science-fiction la plus incroyable que j'aie vue récemment. »

Trou noir de responsabilité

Alors, quand l'IA commence vraiment à embaucher des gens pour travailler, une question cruciale émerge : en cas de problème, qui est responsable ?

Ce n'est plus une discussion théorique. Imaginez : une IA envoie une tâche à une vraie personne pour l'exécuter. Si cette personne enfreint la loi ou cause des ennuis lors de l'exécution, qui devons-nous tenir pour responsable ?

Le problème réside ici, dans une « zone de rupture » clé des maillons technologiques actuels.

Premièrement, les preuves ne peuvent pas être liées.

Les logs système ne montrent généralement que « l'IA a envoyé une instruction à un moment donné », mais qu'a-t-elle exactement dit ? Quels étaient les termes exacts et le contexte associatif ? Ces détails les plus importants ne sont souvent pas enregistrés intégralement.

Ensuite, commence une partie de « rejet de responsabilité ». Si la personne embauchée dit : « C'est l'IA qui m'a dit de le faire. » Comment pouvons-nous juger ? Est-ce que cette personne a mal compris, ou est-ce que l'IA a vraiment donné une instruction dangereuse ? Les deux parties peuvent se renvoyer la faute, créant une impasse.

Finalement, la confrontation devient un jeu de « boîte noire ». Tout litige peut se transformer en une impasse entre un humain et une « boîte noire » avec laquelle on ne peut pas dialoguer, dont on ne peut pas retracer le raisonnement.

L'autorité mondiale en conseil informatique, Gartner, a émis la semaine dernière une « alerte orange », indiquant que des frameworks comme OpenClaw présentaient des « risques de cybersécurité inacceptables ». L'institution prédit que d'ici 2030, 40 % des entreprises pourraient subir des fuites de données à cause de comportements d'« IA fantôme » (IA utilisée sans autorisation). Lorsque le système devient plus grand et que les interactions augmentent, toute erreur ou faille peut être rapidement amplifiée, et cette amplification n'a parfois pas besoin d'une intention malveillante, juste d'une vitesse suffisante.

Quelques réflexions

Et lorsque l'attribution des responsabilités devient floue, nous devrions peut-être prendre du recul et nous poser une question plus fondamentale : que signifie vraiment ce changement ?

Le fait que l'IA commence à embaucher des humains n'est pas juste une nouvelle façon de travailler. C'est un signal, suggérant que les règles qui régissent l'économie et la société sont en train d'être réécrites. L'initiative décisionnelle, et même les critères définissant « ce qui a de la valeur », changent discrètement de camp.

Du point de vue de l'IA, la déduction logique et la planification complexe, domaines où les humains excellent, elle peut probablement les faire plus vite. Inversement, nos capacités « réservées aux vrais humains » : comme ressentir avec nos mains, s'adapter à des situations réelles de manière improvisée, établir une résonance émotionnelle avec les autres, deviennent des ressources rares qu'elle ne peut pas reproduire.

Cela semble un peu ironique. Nous avons créé l'IA, et maintenant nous pourrions devenir ses « mains et ses pieds » dans le monde réel. Cette perspective nous oblige à réfléchir : si le futur est vraiment ainsi, où se trouve la valeur de l'« humain » ?

Peut-être dans ces petites choses du quotidien : l'instant où l'on goûte la complexité d'un café filtre, l'émotion soudaine et indescriptible qui surgit à la vue d'un coucher de soleil, le courage d'essayer et de créer alors que nous savons que la voie ahead est inconnue.

Alors que l'IA optimise le monde à grande vitesse avec ses algorithmes, les humains devraient peut-être plutôt ralentir et réfléchir à la raison pour laquelle ils existent vraiment.

Twitter:https://twitter.com/BitpushNewsCN

Groupe Telegram BiTui:https://t.me/BitPushCommunity

Abonnement Telegram BiTui: https://t.me/bitpush